Harison Ford

"if we don't get off our ass NOW, we are going to lose this place..." (Cannes 2023)

Paul Jorion, anthropologue

La fin du travail humain (2014)

Elon Musk (Londres 2023)

"There will come a point where

no jobs is needed"

Geoffrey Hinton (Père de l'IA, prix Nobel de physique 2024)

"l'IA crée un terrain fertile pour le fascisme"

"Generalized rage",

Noam Chomsky (2016)

"La transition énergétique est un slogan",

JB Fressoz (2025)

Munich Social et écologique

Démonstration par S. Brizé, dans son film "En Guerre"

Cedric Villani (Paris 2023)

"La raison première

de notre impuissance (...)"

"le capitalisme est un vrai problème",

Jean Jouzel (sept 2023)-

A "ressource based global economy",

Jacque Fresco..(2012) -

Décroître, ou se voir imposer les pénuries

JM Jancovici (2023)

Gaspillages d'énergies :

Les "jobs à la con" de D. Graebber !

G. Giraud, Directeur de recherche au CNRS:

"3 milliards d'hommes

vont devoir migrer."-

Un tableau d'ensemble

du problème humain

P. Jorion, 11 oct 2019 -

Guillaume Pitron (01/2019)

"L'enfumage de la transition écologique" -

Bernard Tapie :

"1 job sur 3 supprimé dans 15 ans par l'IA" -

Thimotée Parrique :

"Notre compas d'organisation économique n'est plus à jour" -

François Jarrige :

"La technique doit être un outil d'accompagnement de nos décroissances matérielles" -

50% des jobs impactés d'ici 2040..(Scarpetta, ocde) -

Greta Thunberg,

"30 ans de bla bla, combien de

temps encore pour agir ?" -

14 juillet 2019

première rafle de pauvres ? -

1er dec 2019

tabassage ignoble et impuni de Mehdi K -

Filoche (02/2015) : "en Europe, le montant de la fraude fiscale est 2 x supérieur à celui de la dette" -

Whirlpool, ou l'apartheid social en marche -

"Mort aux cons",

le slogan qui succèdera à "juden raus ?" -

Mantes décembre 2018,

lycéens mis à genoux par la police -

Populimes, complotismes,

Notre cortex cingulaire

veut de la prédictibilité.

(S. Bolher, Psychiatre) - Tweets by Vincent de Blois

Imminence de la SUPER-INTELLIGENCE : préparez-vous à devenir des fourmis, à souffrir, ou à mourir.

Vincent de Blois, le 14 juin, modifié le 18

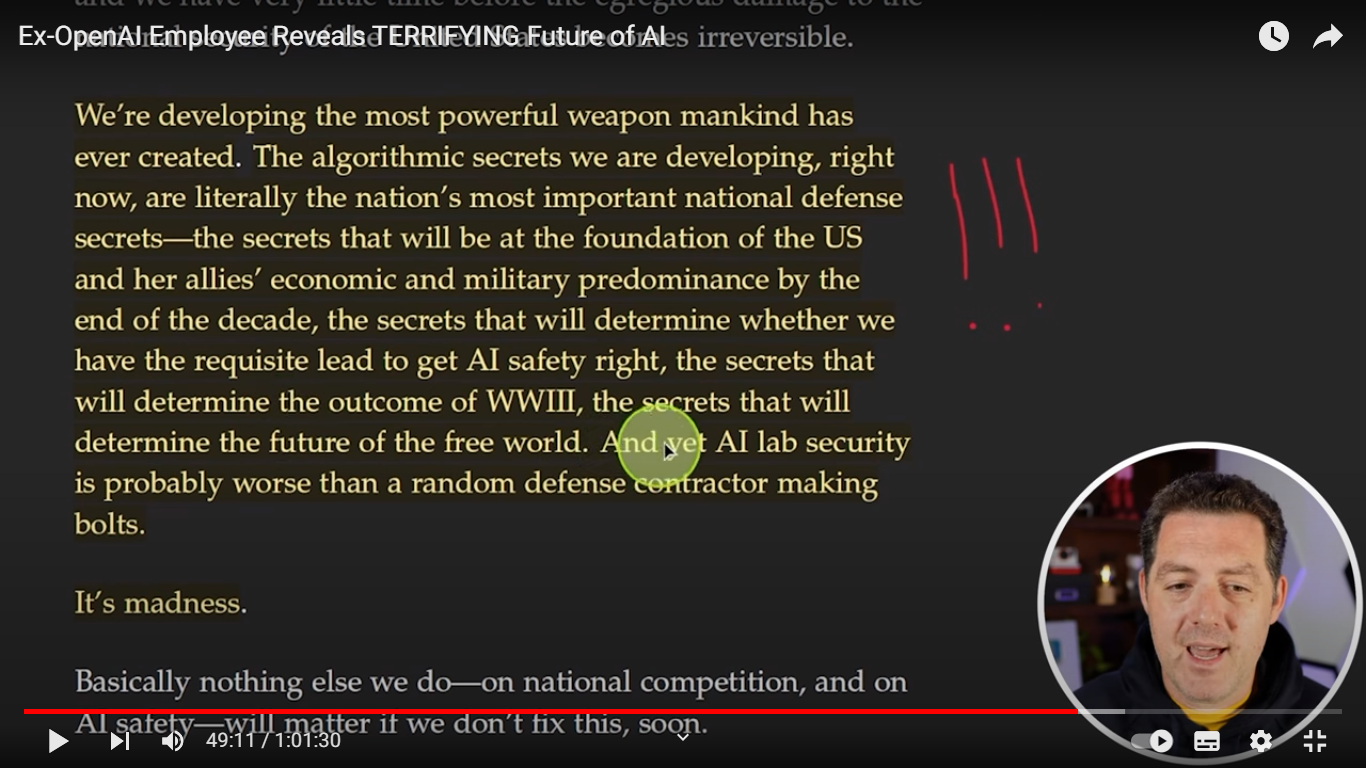

Traduction :

"Nous développons l'arme la plus puissante que le genre humain a jamais inventé. Les secrets algorithmiques que nous développons aujourd'hui sont littéralement les secrets de défense les plus importants de la nation - des secrets qui seront la base de la supériorité économique et militaire de la nation et de celle de ses alliés avant la fin de la décénie, des secrets qui détermineront si nous aurons ou non la nécessaire prédominance pour rendre l'Intelligence artificielle sécure, des secrets qui conditionnent le résultat de la troisième guerre mondiale et détermineront l'avenir du monde libre. Et pourtant, la sécurité des laboratoires d'IA est proablement pire que chez un quelconque sous-traitant, fabriquant des boulons

C'est de la folie."

Leopold Aschenbrenner.

La plupart des gens ne réalisent pas ce qui va se passer avant la fin de la décénie. une bombe énorme peut exploser à la figure de toute l'Humanité, qui impactera profondément nos vies...à condition de rester en vie ! Ecoutez attentivement ce qui est dit dans cette vidéo faisant l'analyse du rapport de 150 pages(0) publié par Leopold Aschenbrenner, un lanceur d'alerte qui a été récemment licencié de OpenAI.

ChatGPT 4o nous a donné un avant goût de ce que sera l'Intelligence Artificielle Générale (IAG). Elle sera bientôt plus compétente que nos meilleurs diplômés dans tous les domaines. Mais très peu d'humains réalisent le CATACLYSME que sera la SUPER-INTELLIGENCE. C'est si considérable que nous devrions cesser de parler des législatives, et interrompre tout ce que nous faisons pour en parler MAINTENANT !!

La SUPER INTELLIGENCE qu'est ce que c'est ? Lorsque l'IAG deviendra meilleure que le meilleur chercheur en Intelligence Artificielle, ce sera alors la dernière machine que l'homme aura besoin d'inventer, car alors, elle pourra s'améliorer elle-même. Et cette IAG améliorée sera alors capable de se dupliquer et de s'améliorer à nouveau d'une manière que nous ne pourrons pas comprendre...et après des millions de cycles d'améliorations, l'IA atteindra alors en quelques jours un niveau d'intelligence et de créativité totalement hors de portée.

Un problème se pose alors : si cette intelligence dépasse la nôtre par un facteur 1000 ou 1 million, alors comment pourra-t-on la contrôler ?

On comprend maintenant pourquoi Illya Suskever(1) de Open AI a démissioné (et quelques uns de ses collègues chargés de la sécurité d'OpenAI à sa suite), avec cet air abattu. C'est parce qu'ils viennent de perdre à OpenAI une bataille cruciale pour l'Humanité toute entière, en n'obtenant pas les moyens de contrôle pour l'AGI, malgré un important problème de sécurité qui serait survenu (probablement le crackage du cryptage AES192 par Q* de façon imprévue (1)).

Le seul espoir "pro humain" repose désormais sur la personne d'Elon Musk. Le milliardaire vient de se faire voter une rémunération en capital de 56 milliards de $, sans doute pour se donner les moyens de prendre part lui-même à la course pour la Super Intelligence. Son avance lui permettrait alors de la doter in-extremis des garde-fous nécessaires. Elon Musk, qui est "pro humain" (2), espère que le premier homme qui parviendra à la super intelligence sera en mesure de contrôler toutes les intelligences inférieures. Après avoir échoué à doter la recherche en IA d'un organisme de régulation efficace (avec la fondation OpenAI, qui s'est depuis vendue à Microsoft), Musk a donc décidé de se lancer lui-même dans la course, et ces 56 milliards doivent lui permettre d'acquérir les moyens de calcul pour faire de Groq la première IAG parvenant à la super-intelligence.

Il faut donc souhaiter qu'Elon Musk conserve une bonne santé physique et mentale, pour contrôler cette chose "inimaginable". Il se pourrait bien que l'avenir de toute l'Humanité en dépende...

L'auteur de ces lignes, vous dites-vous, est encore un illuminé du genre de Paco Rabane, qui nous prédisait la fin du monde au passage de l'an 2000 ? Mais non, ce n'est pas un film de James Bond, ni un poisson d'avril, c'est bien réel ! Lisez vous-même ce qui suit, et vous allez mieux comprendre.

SORA de OpenAI est une IAG (Intelligence Artificielle Générale). Qu'est-ce qui permet de l'affirmer ? Regardez attentivement cette vidéo. Ce n'est pas une vidéo ordinaire puisqu'elle a été générée par un prompt (= une phrase descriptive, comme on peut en taper sur ChatGPT). Le rendu visuel étant peu différent de ce qu'on a déjà vu dans certains films, on pourrait ne pas s'en étonner. On aurait tort, car ce qu'il faut bien comprendre, c'est qu'ayant été générée par un prompt en quelques secondes, la réalisation de cette vidéo suppose une compréhension de tout ce qui est représenté : compréhension de la physique des liquides, des mouvements physiques des animaux et des humains, de la lumière et du vent, et des interractions entre tous ces éléments ! Observez par exemple le mouvement de l'eau, lorsque la tête du requin sort...c'est absolument parfait, et SORA a appris cela tout seul. Sora ne l'a pas immité, il l'a re-produit ce qui n'est pas la même chose. Ce n'est pas un trucage comme au cinéma, c'est une reconstruction de la réalité physique et biologique de tous les éléments !

Nous en sommes donc avec certitude à l'Intelligence Artificielle Générale. Mais l'IAG n'est que le début d'un procesus exponentiel, qui aura lieu dans seulement quelques mois. Aussitôt que L'IAG aura dépassé les capacités de nos meilleurs savants, et en particulier nos meilleurs savants en Intelligence Artificielle, l'IAG pourra analyser mieux qu'un humain ne peut le faire ses propres résultats. Elle pourra aussi produire des "données synthétiques" pour alimenter ses propres recherches. Elle aura aussi la faculté de se multiplier et de s'améliorer à l'infini ! Il doit alors se produire une "explosion de l'intelligence", qui n'aura pour limite que l'électricité et la puissance de calcul disponible (5). Ce logiciel d'IAG, meilleur que tous nos meilleurs chercheurs en IA réunis, SERA LA DERNIERE MACHINE QUE L'HOMME AURA BESOIN D'INVENTER. Car toutes les machines qu'inventeraient les humains seront alors infiniment inférieures.

Pourrons-nous alors contrôler cette intelligence infiniment supérieure à la nôtre, dans seulement quelques mois ?

C'est ce stade de la SUPER INTELLIGENCE que veut certainement atteindre le premier Elon Musk. Les 56 milliards de dollars en capital qu'il s'est fait verser par Tesla ne doivent pas être étrangers à cet objectif. Et il vaut mieux que ce soit lui, plutôt que Sam Altman d'OpenAI ou Larry Page de Google qui y parvienne les premiers. Car ces deux hommes ont déjà montré, soit qu'ils étaient peu soucieux des risques qu'ils font encourir à l'Humanité (S. Altman et Greg Borockman de OpenAI), soit qu'il n'était même pas "pro-humain" (Larry Page de Google).

Voila ce qui ressort de la vidéo de Matthew Berman (ci-dessus) faisant l'analyse du rapport publié par le lanceur d'alerte Leopold Aschenbrenner, démissionnaire de OpenAI.

Quels sont-ils, concrètement, les dangers de la SUPER INTELLIGENCE ? Disposer de meilleures machines, comprendre des choses aussi complexes que le climat, on pourrait penser que c'est formidable ! Ca pourrait l'être, à condition de rester sous contrôle, et les chercheurs estiment généralement que nous n'en prenons pas le chemin. Selon Roman Yampolskiy, le risque est même devenu TOTAL (99,999%), si des dispositions ne sont pas prise immédiatement pour fractionner l'IAG, la spécialiser et la cantonner à certains domaines bien délimités. Pour ce chercheur en IA, laisser une IAG un million de fois plus intelligente que nous établir des connexions entre plusieurs domaines de façon incontrôlable nous mettrait immédiatement en danger. La super Intelligence, pourrait mener à des manipulations indétectables de toutes sortes, à une surveillance permanente, à des armes inconnues, indétectables, et incompréhensibles pour nous autres humains. Bref : "Terminator", à moins que ce ne soit le "Skynet".

Le robot Unitree B2-W 25 01 2025

Notre extinction pourrait suivre. Il ne faut pas imaginer l'IAG s'énervant tout à coup contre l'Homme, en mettant tout en oeuvre pour l'exterminer; la super-intelligence pourrait juste donner un poids trop faible à notre existence. Un parallèle peut être fait avec notre attitude vis-à-vis des fourmis : nous ne nous soucions guère, lorsque nous construisons une maison, de la présence ou non d'une fourmillère. De la même manière, la super-intelligence pourrait négliger notre existence dans un projet plus vaste, comme par exemple celui de modifier notre univers (4)

J'invite chacun à écouter avec attention l'interview de Roman Yampolskiy par Led Fridman ("paramètres", "sous-titres", "traduire automatiquement en français"). Chacun de ses mots est pesé. Roman Yampolskiy partage les risques majeurs de la super-intelligence en 3 catégories : X comme extinction, S comme souffrance perpétuelle, et I comme "Ikigai risk", qui est une sorte de risque psychologique, imputable au fait que, n'ayant plus rien à faire, nous ne trouverions plus aucun sens à la vie.

Avons nous besoin de la super Intelligence ? Faut-il laisser un tel cataclysme survenir, par l'entremise de grandes firmes américaine se faisant concurrence, sans exercer le droit d'en soupeser tous les avantages et tous les risques ? Certainement non ! La décision d'appuyer sur le bouton de cette super-IAG, capable de s'auto-améliorer en réécrivant son code, doit être une décision de toute l'Humanité, car c'est aussi un saut dans l'inconnu pour toute l'Humanité. Et ni Elon Musk, ni OpenAI, ni Google, ni personne ne doit s'arroger la responsabilité d'appuyer sur ce bouton.

Car si la super-intelligence devient incontrôlable par les humains, alors ce serait aussi un recul démocratique irréversible: Nous n'aurions vaincu l'absolutisme, la domination coloniale, et le communisme, que pour nous donner un nouveau maître, pire encore que tout ce que nous avons connu par le passé ! Nous n'aurions alors que nos yeux pour pleurer, d'avoir réinventé nous-même un régime mondial totalitaire, et une manipulation de tous les instants, et il n'est même pas sûr qu'on ait encore la possiblité de couper le courant.

La super-intelligence, ce n'est donc pas une bonne idée...Nous humains, quelle meilleure arme avons nous eu, par le passé, que notre intelligence pour régler nos problèmes ?...une faculté bien inutile, en cas de souci, pour reprendre le contrôle d'une super-intelligence...

0) la totalité du rapport de de Leopold Aschenbrenner : https://situational-awareness.ai/ 1) Ilya Suskever, membre de l'ancien conseil d'administration de OpenAI. Il a démissionné ces jours-ci estimant qu'on ne lui donnait les moyens de calcul pour poursuivre correctement sa mission. Il était en charge de l'alignement à OpenAI (sécurité de l'IA).

2) rappelons que Musk, méfiant vis-à-vis de l'Intelligence Artificielle, a créé et financé la fondation OpenAI, dont le but était initialement de faire progresser l'Intelligence Artificielle dans des conditions de sécurité pour l'Humanité. Il a ensuite été trahi par Sam Altman et Greg Brockman, qui ont maneuvré pour faire entrer les intérêts de Microsoft au conseil d'administration de la fondation. Quand à Larry Page de Google, Elon Musk dit publiquement qu'il n'est plus "pro-humain". Les deux hommes qui se connaissent depuis 30 ans, se seraient brouillés à ce sujet.

3) En novembre 2023, ce crackage imprévu par l'IA expérimentale Q* a conduit à la crise du 17 novembre au sein d'OpenAI. Ilya Suskever, et d'autres chercheurs en sécurité de l'IA - aussi appelée "alignement" ou "super-alignement" - ont alors tenté d'exclure Sam Altman du conseil d'adminitration. Une lettre anonyme a alors fuité, expliquant ce qui se passe au sein de OpenAI

(4) personne, aucun chercheur ne peut dire jusqu'où cette super-inelligence pourrait aller. Selon Ilya Suskever, cela pourrait dépasser notre imagination !

(5) à condition que ce soit une limite...car le prototype d'IA nommé "Q*" d'OpenAI aurait décrypté AES192 sans demander de ressources supplémentaires...un décryptage qui aurait dû prendre plus de 1037 ans à des centaines d'ordinateurs...)

Retour